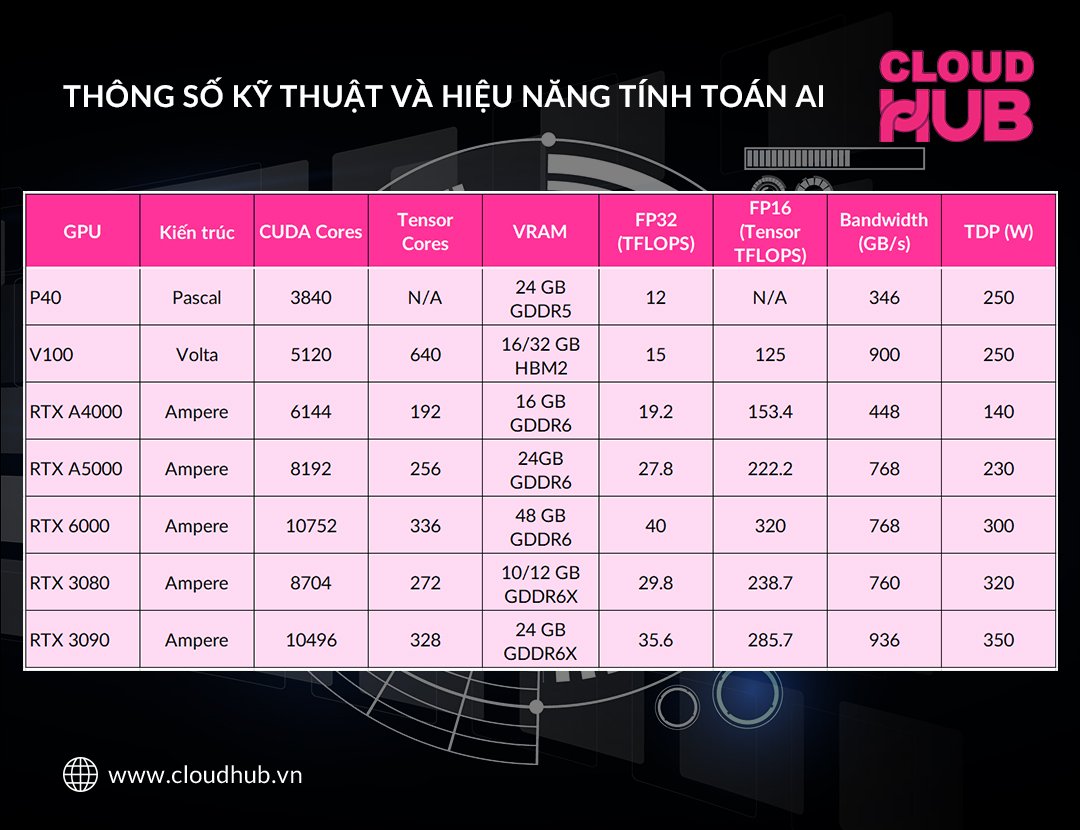

So sánh chi tiết:

1. NVIDIA Tesla P40

- Kiến trúc Pascal: Không có Tensor Cores, chủ yếu dành cho inference hơn là training.

- Hiệu năng FP32: 12 TFLOPS.

- Băng thông bộ nhớ: 346 GB/s.

2. NVIDIA Tesla V100

- Kiến trúc Volta: Có Tensor Cores, rất mạnh mẽ cho cả inference và training.

- Hiệu năng FP32: 15 TFLOPS.

- Hiệu năng Tensor (FP16): 125 TFLOPS.

- Băng thông bộ nhớ: 900 GB/s.

- Ứng dụng: Tối ưu cho deep learning training.

3. NVIDIA RTX A4000

- Kiến trúc Ampere: Có Tensor Cores.

- Hiệu năng FP32: 19.2 TFLOPS.

- Hiệu năng Tensor (FP16): 153.4 TFLOPS.

- Băng thông bộ nhớ: 448 GB/s.

- Ứng dụng: Cân bằng giữa hiệu suất và chi phí, phù hợp cho các công việc AI tầm trung.

4. NVIDIA RTX A5000

- Kiến trúc Ampere: Có Tensor Cores.

- Hiệu năng FP32: 27.8 TFLOPS.

- Hiệu năng Tensor (FP16): 222.2 TFLOPS.

- Băng thông bộ nhớ: 768 GB/s.

- Ứng dụng: Mạnh mẽ hơn A4000, phù hợp cho các tác vụ AI phức tạp hơn.

5. NVIDIA RTX 6000

- Kiến trúc Ampere: Có Tensor Cores.

- Hiệu năng FP32: 40 TFLOPS.

- Hiệu năng Tensor (FP16): 320 TFLOPS.

- Băng thông bộ nhớ: 768 GB/s.

- Ứng dụng: Hiệu năng cao, phù hợp cho các trung tâm dữ liệu và ứng dụng AI chuyên sâu.

6. NVIDIA RTX 3080

- Kiến trúc Ampere: Có Tensor Cores.

- Hiệu năng FP32: 29.8 TFLOPS.

- Hiệu năng Tensor (FP16): 238.7 TFLOPS.

- Băng thông bộ nhớ: 760 GB/s.

- Ứng dụng: Mạnh mẽ, phù hợp cho các nhà phát triển AI cá nhân và các dự án nhỏ.

7. NVIDIA RTX 3090

- Kiến trúc Ampere: Có Tensor Cores.

- Hiệu năng FP32: 35.6 TFLOPS.

- Hiệu năng Tensor (FP16): 285.7 TFLOPS.

- Băng thông bộ nhớ: 936 GB/s.

- Ứng dụng: Một trong những GPU mạnh mẽ nhất cho AI, phù hợp cho các ứng dụng yêu cầu hiệu năng cực cao.

Kết luận

- P40: Dành cho inference với hiệu năng FP32 thấp hơn và không có Tensor Cores.

- V100: Lựa chọn tốt cho deep learning training với hiệu năng Tensor mạnh mẽ.

- RTX A4000 và A5000: Cân bằng giữa hiệu suất và chi phí. A5000 mạnh mẽ hơn cho các tác vụ phức tạp hơn.

- RTX 6000: Hiệu năng cao, lý tưởng cho trung tâm dữ liệu và các ứng dụng AI chuyên sâu.

- RTX 3080 và 3090: Phù hợp cho các nhà phát triển cá nhân và các dự án AI lớn, với 3090 có hiệu năng vượt trội hơn.

Lựa chọn GPU phù hợp phụ thuộc vào yêu cầu cụ thể của dự án AI của bạn về hiệu năng, chi phí và khả năng mở rộng.

Thông tin trích dẫn từ Chat GPT.

CloudHub chuyên cung cấp dịch vụ Cloud VPS, VPS – Gold, VPS – Platinum, GPU VPS, GPU Server.

Fanpage: CloudHub – GPU AI

Telegram: @CloudHub_Notify